Auteur : Léa Sattler avec la participation de Thomas Maigne_

Nous avons vu précédemment que la modalité du BIM est la mise en place d’un système d’information au sein d’un projet : la structuration et distribution des données, à niveau de granularité plus ou moins variable [article II/III]. Or ce système obéit plus à des logiques bottom-up qu’a des tendances top-down, et bouleverse les hiérarchies et workflows traditionnels. Comment un tel système, dans une tension entre outil de gouvernance et d’autogestion, va-t-il bouleverser le monde du travail, de la décision à la production ?

La désorganisation scientifique du travail

Nous disposons d’une métaphore, couramment empruntée à la chirurgie, et qui s’appuie sur le concept même d’opérateur. Le chirurgien apparaît à l’extrémité d’un ordre dont le pôle opposé est occupé par le guérisseur. L’attitude du guérisseur soignant un malade par imposition des mains diffère de celle du chirurgien, qui intervient dans le corps du malade. Le guérisseur maintient la distance naturelle entre lui-même et le patient […] : s’il réduit un peu cette distance – par l’imposition de ses mains – il l’augmente beaucoup – par son autorité. Le chirurgien procède à l’inverse : il réduit fortement la distance qui le sépare du patient – puisqu’il pénètre son intériorité – et l’augmente à peine – par la précaution avec laquelle il meut sa main au milieu des organes. »

Walter Benjamin, L’œuvre d’art à l’époque de sa reproductibilité technique, [1]

A. Profondeur de champ

Avec ce gout persistant pour une logique top-down et linéaire, on débouche naturellement sur la réinstauration de la figure panoptique, celle du contremaître évoquée plus haut – la boucle est bouclée… En effet, une des promesses récurrentes du BIM, louable mais à double tranchant, c’est de donner à voir, d’un coup d’un seul, l’ensemble des données.

Panoptique

Tout d’abord, il convient de noter qu’encore une fois, dans cette injonction du BIM, l’accent est mis sur la finalité, sur la sortie de ces données, l’output… sans se soucier de leur agencement initial. C’est le mythe du bouton sur lequel on appuie, le culte de l’immédiateté ; les acteurs en oublient qu’ils sont eux-mêmes créateurs de données, et qu’il leur revient d’en gérer l’extraction. À titre d’exemple, on nous a déjà demandé sur un projet de faire apparaître sur des plans 2D l’identifiant unique de chaque poutre d’une maquette structurelle, alors que ces noms n’avaient pas été renseignés en amont, ni même pensés… Assiste-t-on à l’émergence d’une d’attitude consumériste vis-à-vis de l’information, encouragée par les logiciels dits intuitifs, qui mènent insidieusement à accepter que la structuration de ses données soit pensée par le logiciel lui-même ? Quid de l’indépendance intellectuelle ? La manière dont on crée et ordonne des données influence pourtant de manière indéniable l’organisation du travail et la production physique qui s’en suit – celle d’un bâtiment. En achetant un logiciel, l’on se plie implicitement aux méthodes de travail qu’il implique et engendre.

De plus, derrière l’idée de sortir toutes les données, il y a l’idée qu’il est possible de tout renseigner, en amont, de manière plus ou moins contrôlée ou automatique par le logiciel. Or, s’il est maintenant certes facile d’agréger des données dans une maquette numérique, il est toutefois plus difficile de les retrouver, d’en faire le tri, de les analyser. Il est aisé de renseigner, d’attribuer, d’ajouter, de rentrer de la donnée ; il est moins évident de structurer, de référencer. Ainsi, cette volonté de tout voir conduit souvent malheureusement, dans une course à l’exhaustivité bon marché, à faire l’impasse sur la phase de hiérarchisation de ces données. On se retrouve ensuite avec des blocs confus d’information indigeste. En outre, cette volonté de tout voir, de manière panoptique, est hautement incompatible et contradictoire avec les logiques d’un système d’information – nous développerons cela plus bas, mais notons déjà simplement la superficialité structurelle d’une vision panoptique, qui procède au scan de l’aspect externe des éléments, ainsi que la constitution statique de ce système élaboré autour sur un point de vue unique, en totale contradiction avec une idée d’information dynamique.

Notons par ailleurs qu’ironiquement, les logiciels qui promettent d’extraire et de donner à voir les des données dans leur exhaustivité, par une sorte d’accès généralisé et flou, sont eux-mêmes les plus black-box et opaques dans leur fonctionnement : ce sont ceux qui donnent le moins d’accès à leur structure interne et à leurs API [2]. Paradoxalement, ceux qui promettent des visions panoptiques miraculeuses dissimulent fortement leur structure interne, tandis que ceux qui se contentent d’être le support d’une construction intelligente de données fonctionnent à cœur ouvert, souvent open-source, et sont aisément accessibles, automatisables – transparents. Ce paradoxe de l’opération black-box et du pouvoir n’est pas sans rappeler le duo guérisseur et chirurgien évoqué par Walter Benjamin [3] : le premier, sans rien manier physiquement, à une action opaque, et beaucoup de pouvoir, via son aura, tandis que le second, qui décortique et manœuvre, peut sembler plus violent mais l’est infiniment moins, dans l’accès délicat qui le conduit aux objets… L’un manipule au sens figuré, l’autre, au sens propre. Cette métaphore trouve un pendant digital dans la distance aux données et les possibilités d’opérations qu’établit une infrastructure logicielle.

Granularité

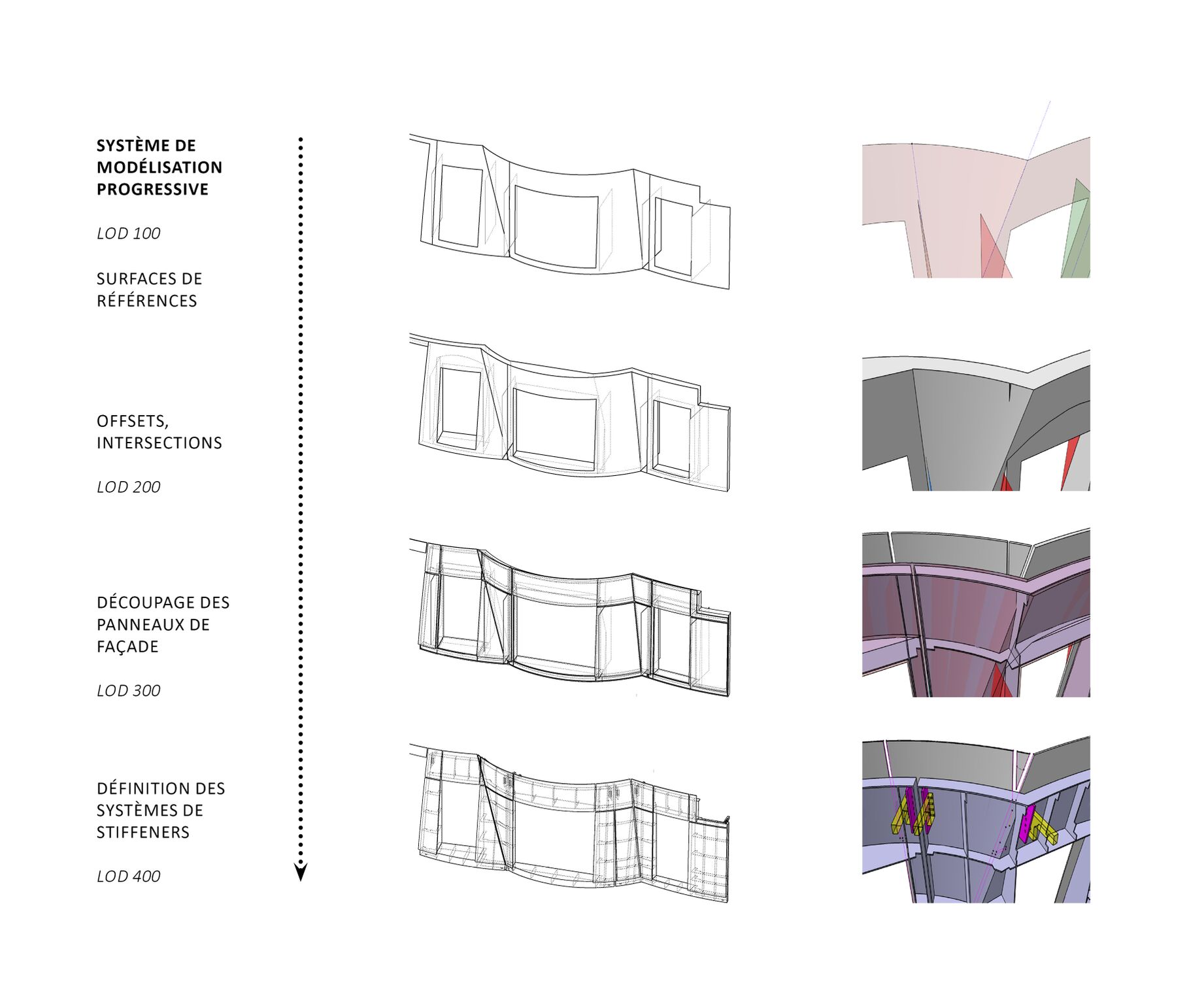

Un système d’information performant doit, grâce aux objets persistants évoqués plus haut, permettre de garder une mémoire des opérations, des différentes actions sur ces composants. Il doit permettre à ces objets d’évoluer selon les phases du projet : d’acquérir de plus en plus de détails, de s’adapter à différentes logiques de travail. Par exemple, une coque de façade, en phase esquisse, est une surface, et n’obéit globalement qu’à une seule entité de logique (le design) et une seule équipe (celle de l’architecte). Puis en phase construction, elle va acquérir de nombreux inputs (interaction avec les autres corps d’état, synthèse, inputs de fabrication, inputs économiques, etc.) et de nombreux outputs (détail 3D, plan de fabrication, simulation 4D, etc.) Plus l’objet s’approche de sa matérialisation, plus il est analysé finement par plusieurs types d’intervenants, et plus il est complexe. Ainsi, un fichier initial va devenir un ensemble de dix fichiers, puis cent, puis mille. Sur la Fondation Vuitton, certains éléments avaient leur propre maquette, indépendante, très détaillée en géométrie et en méta-data, connectée à la maquette principale – c’étaient les cas par exemple pour les verrières et les surfaces courbes dites icebergs.

Système granulaire progressif

Source : M4D (consultante : Léa Sattler, 2017)

Une maquette numérique met donc en œuvre, par définition, des objets granulaires [4], qui pourront être divisés à l’infini, selon la phase et le niveau de détail. Cette granularité est efficace, d’un point de vue purement descriptif, puisqu’elle donne accès à plusieurs niveaux d’information pour un même objet. Mais surtout, elle permet de distribuer et d’organiser finement le travail, et de mettre en place des workflows qui vont petit à petit suivre des logiques métiers, depuis l’architecte jusqu’aux fabricants – et c’est ici que se situe le cœur de l’objet maquette numérique : permettre de rapprocher les intervenants, et in fine, d’abolir des étapes dans la transmission de l’information. Permettre à l’architecte et au constructeur, qui travaillent sur le même objet, à des résolutions différentes, d’intégrer les contraintes les uns des autres.

Et c’est là que la granularité, qui pourrait être assimilée à la notion plus simple de niveau de détail, vient s’en différencier et s’enrichir : elle est intimement liée à collaboration autour d’un objet commun. La granularité, c’est l’idée de résolution d’un composant, couplée à celle du dynamisme des processus liés à celui-ci.

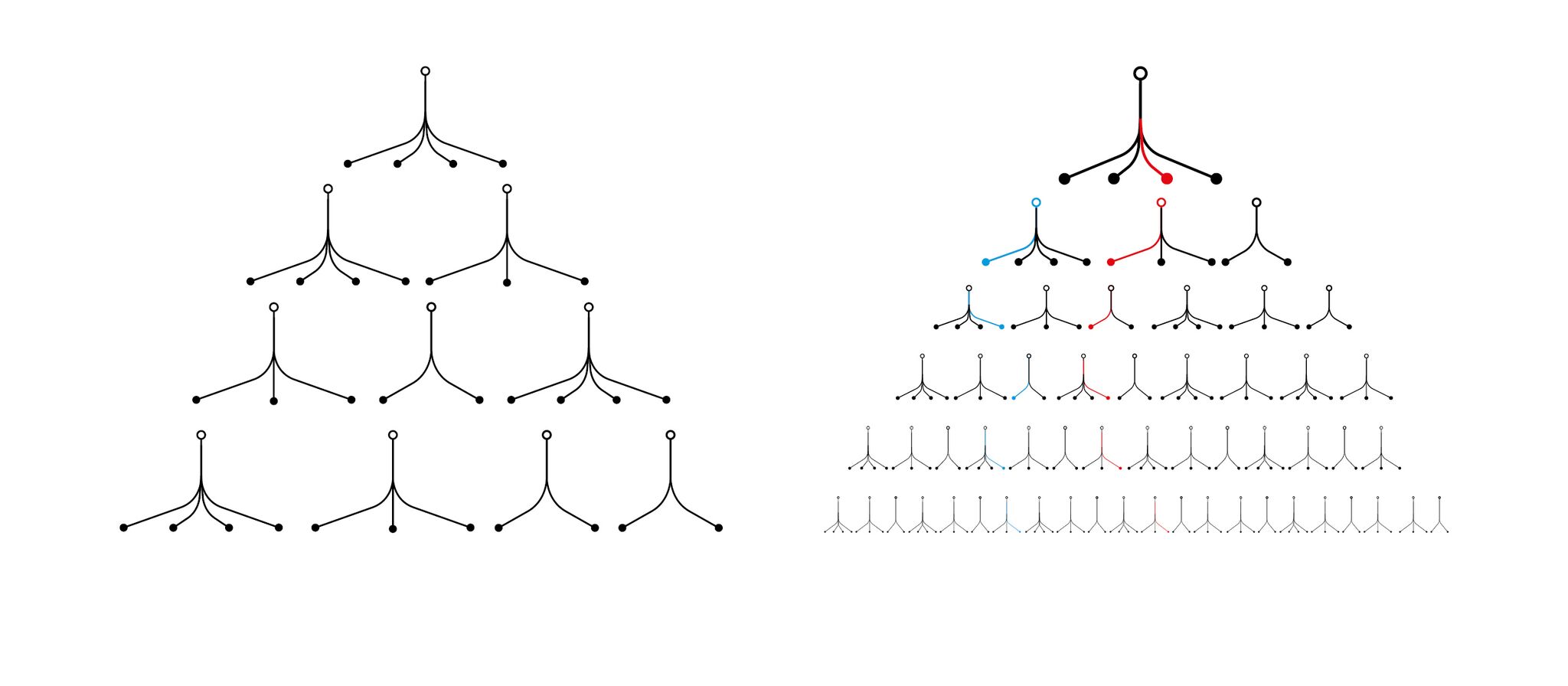

Arborescence

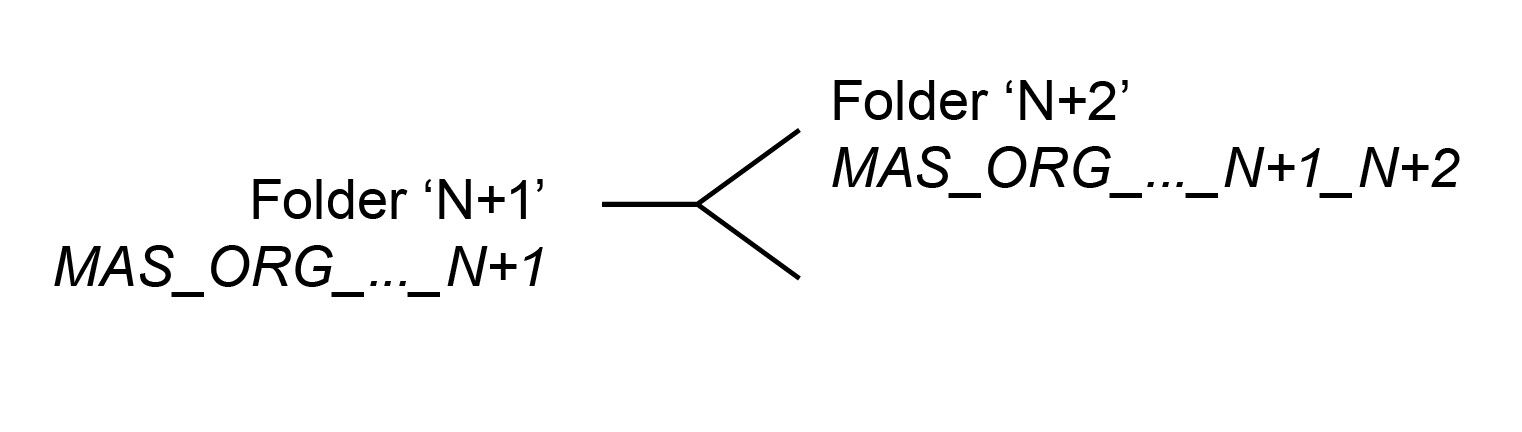

Sur les deux projets de Gehry, nous avons utilisé des organisations arborescentes comme support à ce système de granularité. Ainsi, la seule difficulté réside ici dans le calibrage de cette arborescence : où placer les nœuds ? Quels intervenants auront besoin de quel type et nombre de division ? Il s’agit de comprendre les inputs et outputs de chacun et d’anticiper le parcours d’une information à travers les intervenants et les processus – les boucles, les réitérations.

Ce système est un ensemble mouvant [5] ainsi, l’idéal est de le concevoir de manière à ce que chacun puisse s’y insérer facilement. Ses règles doivent être simples, déclinables, génératives. Dans un pur souci d’économie, et d’une certaine manière, d’élégance organisationnelle, nous avons dessiné l’arborescence du projet de la Fondation Luma comme un ensemble dont la clef tient en une seule règle générique.

Règle d’arborescence

Source : M4D (Thomas Maigne, 2014)

Notons qu’un document est très en vogue dans le BIM : le fameux BEP, ou Bim Execution Plan, qui compile toutes les règles d’une charte BIM, et est souvent un agrégat indigeste de règles, d’exceptions… que personne ne lit, mais qui rassure les décideurs. Un système d’information simple, distributif, tenant en une seule règle, permet de faire l’économie de ce document bureaucratique. Là encore, on économise du temps d’explication, de communication [6]. Sur le projet de la Fondation Luma, les règles sont systémiques et tiennent en une feuille A4. Leur déploiement à l’échelle du projet conduit à un système complexe, certes ; mais la règle originale est simple, chaque intervenant s’y retrouve, et peut comprendre comment l’ensemble est construit. L’idée étant aussi de créer une accessibilité à l’information non par le haut, panoptique, mais par le bas : si l’on comprend la règle de fonctionnement de base, en la déclinant, on peut accéder et naviguer à travers la maquette numérique ; on n’a pas, passivement, accès, mais on accède, activement.

Arborescence

Source : Treegram

Hide/Show

La mise en place d’une méthodologie BIM doit donc permettre aux intervenants de naviguer facilement à travers l’ensemble de données. Notons, sans jouer sur l’ironie de l’expression de l’arbre qui cache la forêt, que le système arborescent a ceci d’intéressant qu’il montre et dissimule à la fois – sans toutefois se « dissimuler devant la simulation » [7]. En effet, si le tronc a un rôle structurant, les nœuds bas d’un arbre à haute granularité sont toutefois peu accessibles depuis la branche maîtresse. Mieux encore, ils sont même relativement indépendants de cette branche, séparés par les ramifications ascendantes, et sont à la portée des initiés, ou des malins. Ainsi, l’arbre cache autant qu’il montre.

On retrouve ce paradoxe cacher/montrer dans la notion d’encapsulation, processus inhérent à la conception d’un programme informatique, et que l’on retrouve dans l’outil numérique powercopie de Catia – composant adaptatif optimisé. Encapsuler, c’est ne plus donner, au moins temporairement, accès à un savoir, ou plutôt, l’enrouler, le compresser, pour ensuite le dérouler si nécessaire. C’est créer une certaine économie de conscience de processus – c’est abstraire. On crée une entité autonome, dont on considère que le fonctionnement est acquis, et n’a plus d’intérêt à être dévoilé. Ainsi, pour créer un objet numérique performatif, il faut cacher temporairement le moteur, quitte à donner un mode d’emploi (les API, le code).

L’ambivalence cacher/montrer montre que l’accessibilité au savoir ne signifie pas la visibilité des contenus et processus. L’information consistante a une profondeur de champ, un relief. Cette focalisation permanente sur l’output, la sortie, le panoptique, nous conduit à oublier les hiérarchies dans l’information, qui sont pourtant évidentes dans le monde physique… Un système d’information devrait avoir pour mission de révéler la complexité, plutôt que de la simplifier ou l’aplatir.

B. What’s next ?

Si le trigramme « BIM » désigne cet ensemble de méthodes numériques de traitement de l’information dans le champ de l’AEC, le cruel manque de définition et conceptualisation de ce terme est remarquable, et jamais ne sont évoqués à son sujet les thèmes inhérents : les systèmes d’information, l’intelligence artificielle, l’organisation scientifique du travail, la question de l’archive. [8]

Fordisme inversé

En effet, les problématiques soulevées sont intrinsèquement liées à ces questionnements : comment définir un objet, comment assurer la persistance de celui-ci à travers conception et production, comment assurer sa distribution, en faire un élément de travail dynamique, qui à son tour, peut générer des entités processuelles. Ce déploiement vient bouleverser l’organisation actuelle du travail : certains rôles disparaissent, comme celui de dessinateur projeteur, d’autres sont créés, comme celui du programmeur 3D, d’autres encore sont bouleversés – par exemple, la position du chef de projet vis-à-vis de la maquette numérique reste à inventer. C’est la logique hiérarchique verticale entière qui est remise en cause, au profit d’une logique bottom-up granulaire et distributive. Il est intéressant de noter que ce bouleversement ne se fait pas par le haut, ou par pure idéologie, mais de manière pragmatique et technologique : cette petite révolution des positions hiérarchiques a lieu de fait car elle permet in fine une meilleure gestion de la donnée et de la production, reflétant la logique de distribution effective de l’information.

Le BIM, idéalement, vient diviser un workflow de production en entités de travail à l’intérieur desquelles tout ce qui peut être automatisé l’est, pour ne confier au travailleur que la partie de réflexion et de conception. En cela, c’est l’exact opposé de la logique fordiste, qui vient segmenter le travail et réduire les tâches à leur unité la plus petite et stupide, afin de confier au travailleur leur répétition, rapide et efficace. Là où le fordisme ne gardait que la tâche idiote afin de planifier la mise en œuvre de sa répétition intensive, le BIM, avec l’intelligence artificielle, conserve uniquement la tâche qui requiert réflexion, et planifie l’automatisation de toutes les autres. En cela, on pourrait parler de fordisme inversé : la tâche atome, pour le BIM, c’est la pensée ; dans le travail à la chaîne, c’est le coup de marteau ou un boulonnage [9]. Tout se passe comme si l’on passait d’une logique de division du travail à une logique de mutualisation, de synergie.

Le BIM laisse donc espérer de nouveaux modes de management dans l’industrie AEC – à commencer peut-être par l’éradication du mot management même, à l’instar de Larry Page, le fondateur et CEO de Google, qui a un beau jour, en 2002, brutalement congédié tous ses managers [10], ou tout au moins, comme le professait John Kenneth Galbraith en 1967, l’invention d’une « nouvelle race de managers à l’esprit scientifique, qui sauraient mieux gérer ces organisations comme les machines efficaces qu’elles […] sont en train de devenir » [11]. Retenons ici le mot scientifique…

Politique

Toutefois, on a vu à quel point cette révolution est lente, poussive, et la résistance en haut est sévère. Cela se ressent avec ce basculement entre les deux générations d’outils numériques dits BIM : la première, tirée vers le haut par l’exigence géométrique de bâtiments à morphologie complexe, prenait très au sérieux la structuration et création d’une donnée consistante ; la seconde, actuelle, insiste sur la gestion d’une donnée moins précise, plus massive. Tout comme si l’on était passé d’une logique qualitative à des considérations purement quantitatives. Une pratique de recherche et développement, de programmation perpétuelle, s’est muée en pratique de manipulation de solutions logicielles (sans, on le notera, qu’aucune problématique n’ait été clairement énoncée), lourdes boites noires peu accessibles à l’automation. Le BIM, initialement censé apporter de la clarté et réduire les intermédiaires, a laissé place à des logiques bureaucratiques qui viennent finalement rajouter une épaisse couche d’opacité entre les intervenants. Les logiques commerciales des groupes CAO/BIM, qui distribuent aux grands groupes de BTP leurs softwares plus ou moins gratuitement [12], tendent à réinstaurer, avec cette idée de contrôle massif d’une data non-structurée, une logique top-down panoptique anachronique.

C’est regrettable : paradoxalement, c’est bien dans l’industrie AEC que cette révolution pourrait avoir lieu. Nous émettons ici l’hypothèse selon laquelle la dimension multi-entrepreneuriale du BTP, ainsi que la petite échelle des projets, en termes de production et de durée, leur aspect prototypique, toutes ces caractéristiques qui ont justement contribué à l’archaïsme et à la légendaire désorganisation de cette industrie, constituent soudain un terrain propice à un réagencement des modes de travail selon des organisations plus fines et intelligentes. Ce bouleversement n’a pas eu lieu dans les industries classiques, ou la logique top-down prédomine toujours, pour la bonne raison qu’il est facile de garder le contrôle d’une usine, de processus globalement linéaires…. Il est en revanche moins facile de garder le pouvoir dans un système foisonnant.

Déprogrammer l’obsolescence

On en revient finalement à cette question du pouvoir et de l’outil digital. Comment garder le contrôle du projet, sans garder celui des méthodes numériques d’information ? Les grands éditeurs de logiciels de CAO/BIM gardent la main sur leurs processus via plusieurs leviers : non-ouverture à l’automation (création d’une dépendance vis-à-vis de l’infrastructure), lourdeurs des interfaces (création d’une dépendance technique de l’utilisateur), et non réversibilité. Ce dernier pan, c’est la fabrique de l’obsolescence du logiciel : mettre chaque année sur le marché des nouvelles versions d’un logiciel, dont on ne peut éditer les fichiers natifs avec une ancienne version…. ce qui rend donc celle-ci caduque. Outre l’assujettissement qu’ils créent, avec cette obligation de mettre à jour le software d’années en année, c’est aussi une manière de prévenir tout progrès, toute indépendance dans le processus d’amélioration : si l’interface change tous les six mois, cela décourage toute tentative en interne de créer des extensions sous forme de plug-in pour les customiser… On s’en remet alors à la solution logicielle dans son intégralité. Cette stratégie d’obsolescence programmée est peut-être la plus vicieuse – au fond ce qu’elle vise, c’est de rendre obsolescente, en soi, cette pratique libre et open-source de la programmation BIM.

Déprogrammer l’obsolescence des méthodes numériques préexistantes est donc un acte de résistance. Il est bien sûr hors de question de dédaigner ou d’écarter les nouveaux outils digitaux sortant chaque jour – la veille technologique étant désormais indispensable à toute méthodologie, quelle que soit la discipline. Par contre, il nous semble nécessaire de continuer en parallèle à développer, avec ténacité, les méthodes numériques amorcées sur chaque projet BIM, qui ont fait leurs preuves. Rappelons-nous qu’un logiciel gratuit, ou quasiment gratuit, comme beaucoup de softwares plus ou peu développés, n’intéresse personne puisqu’il n’est pas lucratif [13]. Rappelons-nous aussi que bien des fois, automatiser des tâches, afin de les rendre moins fastidieuses n’intéresse personne non plus – le système économique en background n’incitant pas forcément à changer les modes de production de l’information. [14]

Ainsi, continuons à mettre en œuvre dans l’industrie AEC les méthodes qui, en termes de rendement de l’information, fonctionnent dans les industries lourdes depuis des décennies, et laissons Autodesk réinventer la roue de son côté, consolider son monopole. Des méthodes numériques industrielles existent, elles sont accessibles – customisons-les : leur utilisation inventive, voire détournement, est le seul intérêt du BIM. Notre expérience de gestion de deux projets de Gehry sur Digital Project nous montre qu’avec ce logiciel basé sur Catia V5, dont le moteur de modélisation a déjà presque vingt ans d’âge, quasiment open-source en ce qui concerne son automation, puisque la collection d’objet, classes et modules est disponible sur internet, on arrive à repousser les limites, et créer des processus de collaboration et d’analyse de données innovants [15]. Et rappelons-nous qu’il n’est nul besoin d’une Rolls Royce numérique pour travailler intelligemment : une utilisation structurée de Rhino, via Grasshopper, de Processing, et de n’importe quel service d’hébergement cloud, est une gestion BIM d’une efficacité et adaptabilité infinie, qui ne coûte quasiment rien, et donne indépendance. Nous avons à portée de mains un vivier d’outils numériques à combiner à souhait, dont il est urgent de se saisir, afin de décider de l’usage que nous voulons faire de cet objet maquette numérique. Dans le contexte actuel, où le big-data réveille les problématiques de surveillance et protection des données – de liberté, il serait paradoxal et obsolète de se laisser dicter un tel usage par des éditeurs de logiciels et des lobbies numériques…

Remerciement : Thomas Maigne, à qui je dois les notions de granularité et d’ontologie au sujet du BIM. C’est un des concepteurs des systèmes BIM des projets de la Fondation Louis Vuitton à Paris, et de la Fondation Luma, à Arles, et sans lui, cet article n’aurait jamais vu le jour. Christian Girard, pour son soutien et relectures. Pierre Cutellic, pour nos discussions, et Gabriel Daguet, pour sa réactivité sur google image.

[1] Éditions Allia, 2014 (1936 pour l’édition originale), p67.

[2] Application Programming Inteface, soit l’interface d’automation d’un logiciel.

[3] Voir à ce sujet la note ci-dessus.

[4]T. Maigne aborde ce thème de la granularité dans son texte sur la Fondation Louis Vuitton. Évoquant les nouvelles approches que l’ingénieur BTP doit réinventer, il estime que « La première est la granularité. Son environnement n’est plus une feuille de papier avec une échelle prédéterminée, mais un paysage aux dimensions multiples (géométrie, méthodes de construction, temps, objets…) dans lequel il va devoir déterminer son propre chemin. » Thomas Maigne, La 3D Avatar du dessin, in The Fondation Louis Vuitton by Frank Gehry, Paris, éditions Flammarion, 2014.

[5] On pourrait même parler ici d’un ensemble d’objets vivants : « L’objet informatique ainsi « instancié », cloné d’après un modèle, est capable « de recevoir, de stocker, de traiter et d’émettre » de l’information de façon autonome sans intervention humaine, c’est-à-dire de devenir un objet vivant selon la définition qu’en donne Michel Serres. » Thomas Maigne, op.cit.

[6] Notons au passage l’injonction paradoxale qui consiste à mettre en place un système BIM complexe qui nécessite dix heures de lectures pour l’utiliser – tout le temps gagné en productivité est perdu dans l’étude fastidieuse de la notice du système…

[7] Christian Girard, « L’architecture, une dissimulation. La fin de l’architecture fictionnelle à l’ère de la simulation intégrale » in Modéliser & simuler. Épistémologies et pratiques de la modélisation et de la simulation, Éditions Matériologiques, 2014.

[8] Nous n’avons pas développé ce thème crucial, qui est la question de la maquette numérique de maintenance ou d’exploitation– cela fera l’objet d’un développement futur.

[9] « Nous nous demandons si le véritable résultat du développement des ordinateurs ne sera pas précisément de libérer la pensée des tâches algorithmiques et mnémoniques, pour mettre en évidence une pure conscience, irréductible à tout calcul et à toute inscription. De la même façon que Leroi-Gourhan expliquait comment la station debout avait libéré la main de la locomotion pour décharger les mâchoires de la préhension et de l’instrumentation, et ainsi ouvrir la voie à l’articulation des sons pour le langage, nous pensons que l’Homo cyberneticus va bientôt développer d’étranges facultés d’une conscience amnésique et analgorithmique. […] Nous serions sur le point d’achever un formidable mouvement de torsion en philosophie suivant lequel la conscience redeviendrait un centre d’intérêt, non plus comme lieu de la raison, mais comme lieu d’une irréductible déraison. » Bernard Cache, « Objectile : poursuite de la philosophie par d’autres moyens? » in : Les Cahiers du Musée National d’Art Moderne, n°82, Hiver 2002/2003 (Paris, éditions du Centre Pompidou, 2002) p113

[10] A ce sujet, excellent article : “The Untold Story of Larry Page’s Incredible Comeback”, Nicholas Carlson, www.slate.com

[11] Jeremy Rifkin, La fin du travail, op. cit., p.82.

[12] Une stratégie courante d’Autodesk est d’inclure automatiquement Revit dans les packages logiciels des grands groupes, qui, s’ils refusent Revit, se voient retirer leur compte « client privilégié ». Ainsi, il leur revient moins cher d’acheter Revit que de… ne pas l’acheter.

[13] Il y a une étrange corrélation entre le prix d’un logiciel et la confiance qu’il inspire. Par exemple, Rhino (McNeel) ne serait pas assez cher pour rassurer les grands groupes de BTP, et est donc peu utilisé par eux…

[14] Dans le BTP, il est plus courant de « vendre des prestataires », que l’on peut contrôler, sur lesquels on a du pouvoir, que des logiciels et des outils d’automation.

[15] Partenariat avec Dassault Systèmes. À tels points que certains ont été présentés, en feedback, à Dassault Systèmes. À titre d’exemple, le consultant BIM T.Maigne a mis au point sur la Fondation Luma un processus d’automatisation d’extractions de dessin qui fonctionne sur l’ensemble des maquettes du projet, quel que soit le niveau de détail. Une extraction 2D, qui prenait 3 jours sur la fondation Vuitton, prend désormais 10 minutes sur le projet d’Arles – c’est-à-dire que l’on ne se préoccupe pas de la 2D, c’est acquis. Automatiser, c’est aussi “passer à autre chose”… Préparer d’autres savoirs.